人脸识别的技术盲区与隐私边界:当面孔成为大数据,您还安心吗?

Published by“刷脸”进门,“靠脸”吃饭......在人脸识别技术日渐成熟的今天,这些曾经的想象已经无限接近于现实。在人脸识别一路狂奔的同时,技术开发所涉及的隐私问题日渐暴露,应用中的弊病也逐渐凸显。

试想,在简单“刷脸”就能完成一切的同时,你的五官数据将永远成为网络数据集的一部分,甚至有可能被不同的机构调用。人脸识别所带来的并不只是便利、高效和未来感,在现阶段,它应该更多地与伦理、审查、规范化相联系。

当研究数据被永久存储,如何划定隐私边界

当你走进一家坐着20个人的咖啡店,至少会有22个摄像头在你身边:每个人的手机里有一个,另一个通常高高悬挂在角落。你说的内容可能被偷听或被发布出去,你甚至可能出现在另一位顾客的自拍或视频会话背景中。但即使最注重隐私的人也不会因此而拒绝进入咖啡店,因为人们都能接受进入公共场所固有的风险。

正是这种对隐私的“合理”期望,使那些需要在公共场合采集人脸识别研究对象的研究者心安理得。但是,当公共场合采集的信息成为了永久且开放的数据集,如何划定“合理”的隐私边界,就成为了一片学术伦理尚未完善的灰色地带。

成为数据集的研究对象

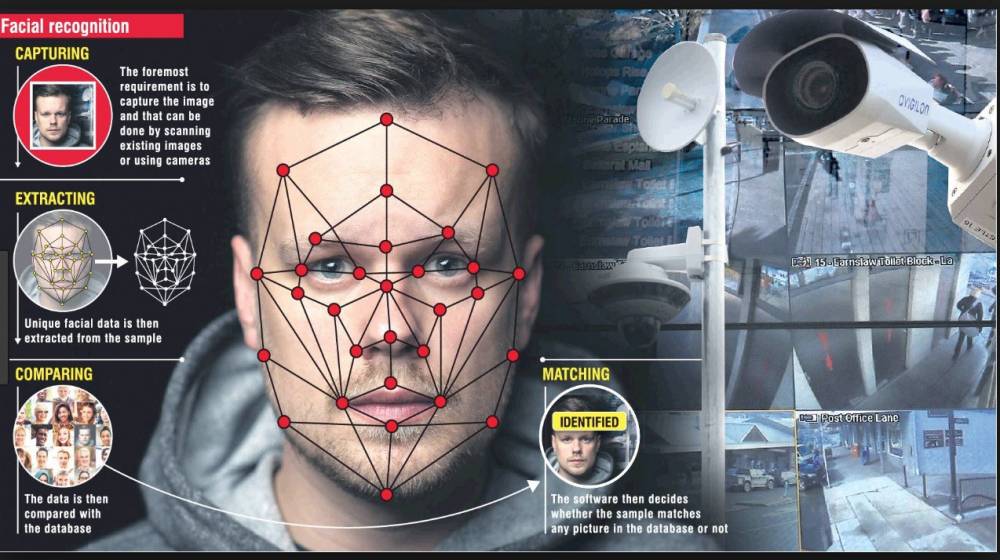

杜克大学、斯坦福大学和科罗拉多州立大学多泉分校的学者们,都利用了校园监控作为捕捉研究对象的手段,但这一行为引起了强烈的反对。虽然人们对在咖啡店里被人偷听有心理准备,但却没有想过会突然变成研究对象,更何况,被录入的研究对象将永远成为数据集的一部分。

有限的监管和失控的后果

在科罗拉多州立大学多泉分校,首席研究员表示虽然他们通过学生数据来测试技术,但是团队从未收集过具体到个人的识别信息。在独立声明中,大学们都重申IRB批准了所有研究,并强调了其对学生隐私的承诺。

但问题在于,大学伦理委员会的监管范围是有限的。他们主要关注研究是如何进行的,但对研究将会如何结束,后续会产生什么影响却并不关心。

在信息时代,大多数学术研究都依靠互联网,而互联网上的信息将永远存在。为其他研究人员开放数据集会增加伴生风险,但IRB在这一方面并没有多少管辖权。因为从根本上说,数据共享与研究本身并不是一回事,因此它处在“一个奇怪的灰色监管地带”了。

如果IRB对研究可能导致的后果漠不关心,那么其他不受IRB标准约束的研究人员,就可以下载数据集并按照他们的意愿随意使用。而被研究的对象却对自己正在被研究这件事全然不知,这可能会导致各种消极的后果。

这些后果或许远远超出研究人员的想象。德国反监视专家Adam Harvey在全球范围内发现了100多个引用杜克数据集的机器学习项目。他创建了一张地图,用于追踪这一数据集在全球的传播情况,就像飞机的航线图一样,从杜克大学向各个方向延伸出长长的蓝线,指向世界各地的大学、初创企业和研究机构。

解决尝试:建立学术审查系统

杜克大学最终决定删除与该研究相关的数据集。斯坦福大学清除了研究人员基于旧金山咖啡馆的顾客所创建的数据集。

科罗拉多大学博尔德分校信息科学系助理教授Casey Fiesler撰写了关于在研究中使用公共数据的伦理学。Fiesler提出了一种用于审查数据集访问的系统,与审查版权类似。她指出,系统中的使用条款主要关注请求者计划如何使用该数据。

“为这些数据集设置守门人是一个好主意”,她说,“因为只要明确使用目的,请求者就能够访问数据集。”类似的规则在开源软件和Creative Commons的标准化版权许可协议上已有应用。

Creative Commons是一种基于许可的系统,请求者只能将获得的作品作为非商业用途,而一旦他们隐瞒或歪曲意图,则需要承担责任。这些标准可能与学术环境并不完全匹配,但至少在切断后续伤害方面是有用的。“这并不是将规则繁琐化,但它提出了一种方法,使得你无论决定要做什么时,都把前后因果考虑进去”,Fiesler说。

您的脸还属于您自己吗?

当人脸识别技术走出实验室,走进现实生活,它就被赋予了更多意义——你的脸将不再只是一张具有生物属性的脸了。在足球比赛中,你的脸是货币,用于在体育场购买食物。在商场,它是一个账本,用于告诉销售人员你过去的购买行为以及购物偏好。在抗议中,你的脸会反映出你过去被逮捕的历史。即使在太平间,脸也能帮助官方机构识别遗体。

随着人脸承载的意义不断加强,技术错误导致的后果严重性也随之增强。在现阶段的应用中,人脸识别技术的一些弊端已经暴露,虽然学术伦理和技术盲区的问题正在逐步解决,这也可能是我们拥有自己面孔的最后时光。终有一天,我们的脸将不再属于我们,因此我们对这项技术的了解,将决定我们会成为受益者还是受害者。