--title--

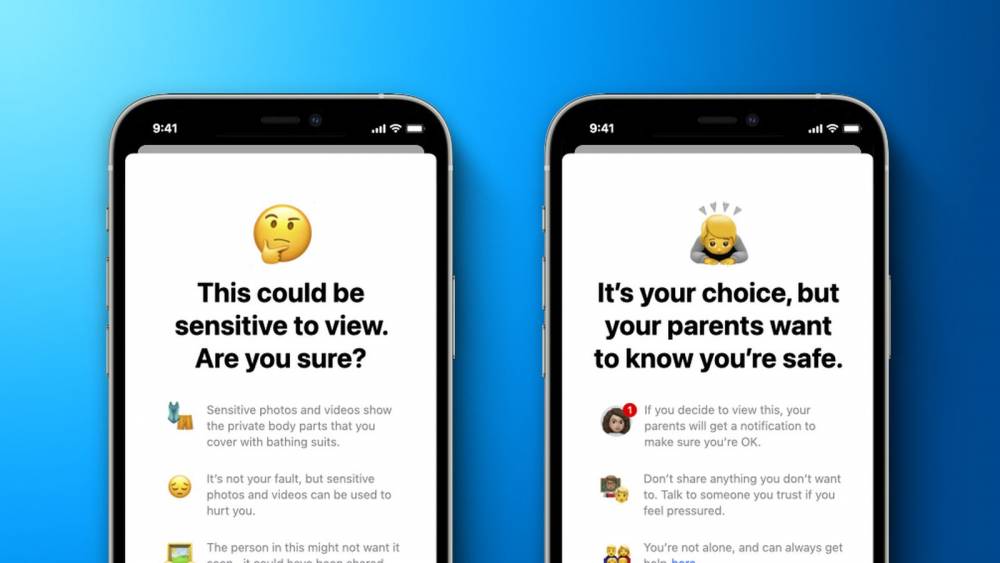

自苹果公司从上周开始推出“儿童安全”功能,对苹果用户们的手机与云端进行扫描以打击儿童色情的内容,虽然此举是为了打击儿童色情活动,加大保护儿童的计划,但却引来维护隐私运动人士的反对,表示他们会因此而失去该有的隐私权。这个新功能自推出以来就饱受用户的质疑,私隐问题的担忧一度爆发,毕竟相册照片一旦上传到云端,后台的工作人员就能随意查看,用户的不满和焦虑也实属难免。

苹果公司软件工程高级副总裁Craig Federighi近日在接受《华尔街日报》的采访时,对这项极具争议性的儿童安全功能进行了辩护,透露苹果公司在扫描用户照片库中的儿童性虐待材料(CSAM)保障措施的新细节。

“该检测算法全程都会在手机本地完成,例如,用户需要在其照片库中满足约30个CSAM 内容的匹配,苹果才会被提醒,而且只有当用户达到30张已知儿童色情图片的匹配门槛时,苹果才会知道用户的账户和这些图片的情况。”

另外,Craig Federighi 也强调在整个过程中,苹果公司都不会知道用户相册中图片的具体信息,只是本地算法在通过比对后,会告诉苹果这部手机中可能有相关内容,向用户解释不用担心隐私的问题。据悉,这套系统只会套用在美国,而且只有在用户打开iCloud 照片后才能启用。

资料来源:快科技

0

0

0

0

0