苹果8月6日在官网上贴文表示,未来将会严厉审查用户在iCloud上的照片,防止儿童色情图片的传播!

这项审查功能将会套用在iOS 15,iPadOS 15,watchOS 8和macOS Monterey的近期版本更新,有关审查系统“NeuralHash”将会通过与美国国家失踪与受虐儿童中心(NCMEC)提供的数据对比,如果审查的iCloud账户核实,将会移交NCMEC与执法部门处理。

(图片来源:YouTube)

打击儿童色情素材传播

苹果的这项“NeuralHash”系统将会套用在iOS 15中,目的就是为了打击儿童色情与性虐素材传播,针对可能会有用户质疑,储存在iCloud上的照片岂不是会被苹果看光?苹果则表示备份到iCloud的照片不会自动被扫描,而是当满足了特定的CSAM侦测值,加密凭证之后才会启用。

实际上现在许多云端服务公司,包括Dropbox,Google和微软,都会针对使用者可能违反服务条款或是潜在非法内容进行扫描。

(图片来源:苹果)

部分用户不满

但苹果这次的决定还是令不少用户表示不满,也有安全专家呼吁苹果对使用者推出有关技术之前,应该要先进行更多公开讨论。

苹果这种举动也引起许多人担忧,因为苹果一向来不断强调自家产品非常注重隐私,一旦开始先例,就会跟政府扩大合作范围,可能会让其实质上监控一切。

实际上,苹果早就在起电邮系统中使用“Hashing System”确保邮件内容没有儿童色情图片。

(图片来源:苹果)

避免技术被中国利用

NeuralHash审查系统苹果释出了三个版本文件,由审查系统技术团队分享部分运作原理,但没有公开合作伙伴身份,苹果表示,一方面是为了避免技术被中国政府利用,因为中国政府长期想要掌握中国国民iPhone的使用者数据。

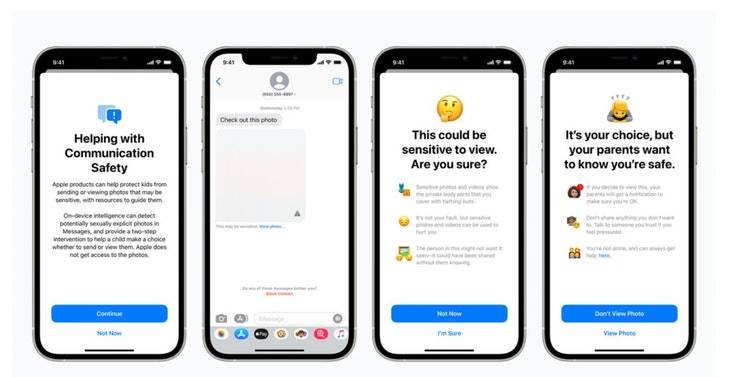

另外,苹果也增加了iMessage对儿童账号附加照片审核功能,当侦测到有问题的图片,会模糊处理并且出现警示,父母的iCloud也会收到通知。

苹果也研究避免SIRI出现语音搜寻儿童色情的问题,并且告知搜寻者这种行为是有害,有风险疑虑的。

文章资料来源:Inside